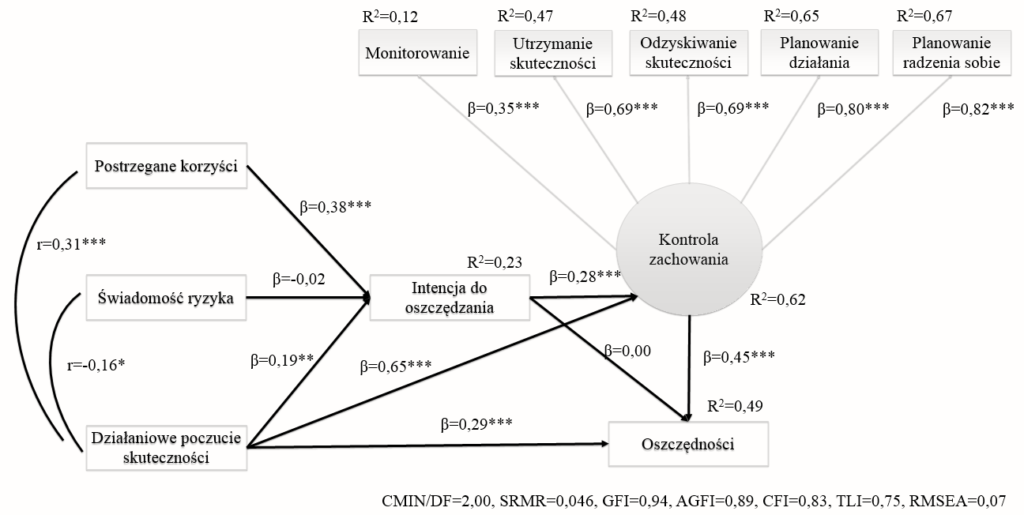

Modelowanie równań strukturalnych: Indeksy dopasowania, wielkość próby i zaawansowane zagadnienia.

W tym wpisie serwujemy starter modelowania równań strukturalnych dla naukowców zajmujących się badaniem zachowania. Kolejno będziemy opisywać podstawy, model pomiarowy, model strukturalny oraz połączony w pełni strukturalny model. Następnie będą omówione zaawansowane kwestie zawierające indeksy dopasowania, wielkość próbki, moderatory, dane podłużne, mediacje itp.

Modele równań strukturalnych (SEM) to ważne narzędzie w warsztacie badawczym. Tym wpisem chcemy zachęcić do częstszego i bardziej kompetentnego użycia równań strukturalnych. Będą dyskutowane zaawansowane kwestie zawierające to jak włączać moderatory, jak myśleć oraz jak myśleć o modelowaniu danych podłużnych. Zaczniemy od tego czy są możliwości dla dwóch bardzo ważnych i rozpowszechnionych kwestii technicznych – kłopotliwych wyborów pomiędzy wskaźnikami dopasowania a pytaniem o wymaganą wielkość próby.

Indeksy dopasowania.

Kiedy oceniamy model mamy do wyboru zbadanie kilku indeksów dopasowania. Kiedy modelujemy analizę regresji, badacze raportują miarę R Kwadrat. R Kwadrat jest opisowym indeksem, który ocenia dobroć dopasowania będąc nieco subiektywną miarą. Czy R Kwadrat równe 0,5 jest dobre? Może R Kwadrat 0,3, a może 0,1? Nie ma tutaj instrukcji, tak więc jest pożądane uzupełnienie tego o test F. Test F jest statystyką mogącą testować hipotezę zerową ponieważ pochodzi z odpowiadającego statystycznego rozkładu. Test F mówi nam czy model chwyta istotną ilość wariancji. W kwestii oceny modelu równań strukturalnych jest mnóstwo indeksów dopasowania. Np. w sekcji „dobroci dopasowania” wydruku z obliczeniami program Lisrel pokazuje 38 różnych wskaźników dopasowania. Wszystkie one służą do optymalizacji nieco różnych funkcji modelu – wskaźniki różnią się w zależności od tego czy są powiązane z wielkością próbki czy nie, albo czy oceniają absolutne dopasowanie czy dopasowanie względne do modelu odniesienia. Razem te różne wskaźniki dostarczają uzupełniających się informacji. Gerbing i Anderson (1992) opisując sytuację będącą analogicznie trudną w odpowiedzi na pytanie „Jaki jest najlepszy samochód na rynku”. Odpowiedz jest taka, że nie ma najlepszego samochodu. Definicja najlepszego samochodu zależy od przeznaczenia? Czy życzysz sobie prowadzić szybki samochód, stylowy czy bezpieczny? Co więc do dobry modelarz analizy równań strukturalnych ma robić? Ten tekst oferuje przebrnięcie przez bagno statystyk dopasowania. Po pierwsze jest trochę zgody, że badacze powinni raportować następujący profil wskaźników. Chi kwadrat (oraz jego stopnie swobody oraz wartość istotności statystycznej), standaryzowany średni kwadrat reszt (SRMR), porównawczy indeks dopasowania (CFI). Idealnie dla modelu jest tak, że dopasowanie do danych oznacza, że test Chi Kwadrat jest nieistotny (p>0,05), SRMR był by blisko wartości 0,09 (lub mniej) a wskaźnik CFI byłby blisko 0,95 (lub wyżej). Przeanalizujmy więc te indeksy. Wśród wskaźników dopasowania w modelowaniu równań strukturalnych Chi Kwadrat jest tylko formalną statystyką, wszystkie inne są opisowe. Tylko dzięki testowi Chi Kwadrat możemy dokonać stwierdzenia odnoszącego się do istotności lub testowania hipotez, i dla innych, istnieją tutaj tylko „reguły kciuka” do oceny dobroci dopasowania. Może się wydawać, że tylko test Chi Kwadrat powinien być raportowany w statystycznym raporcie. Jakkolwiek, Chi Kwadrat ma swoje własne problemy. Najważniejszym z nich jest to, że Chi Kwadrat jest wrażliwy na wielkość próby. Podczas gdy jest ważne by mieć dużą próbę do wzmocnienia precyzji estymacji parametrów jest tak, że kiedy N próby wzrasta Chi Kwadrat uderza w górę. Wynik Chi Kwadrat niemal zawsze będzie istotny (wskazując słabe dopasowanie) nawet tylko ze skromnym rozmiarem próby. W rezultacie zostało zasugerowane z lekkim konsensusem w psychometrycznej literaturze, że model wykazuje dopasowanie jeśli statystyka skorygowana poprzez jej stopnie swobody nie przekracza wartości 3.0.

SRMR oznacza „średni standaryzowany kwadrat reszt” Różnice pomiędzy danymi a modelem predykcyjnym zawierają reszty, których jest policzona średnia oraz pierwiastek kwadratowy. SRMR jest indeksem złego dopasowania (większe wartości sygnalizują gorsze dopasowanie danych do modelu strukturalnego), miara rozpościera się od 0,00 do 1,00. SRMR wynosi zero kiedy model predykcyjny ma perfekcyjne dopasowanie. SRMR jest wzmacniane (zmniejszane) kiedy model pomiarowy jest czysty (wyższe ładunki czynnikowe). Indeks jest bardzo dobrym wskaźnikiem czy model badacza chwyta dane, ponieważ jest relatywnie mniej wrażliwy na inne kwestie jak naruszenia dotyczące założeń o rozkładzie.

CFI (Comperative Factor Index) jest „porównawczym indeksem dopasowania” i w przeciwieństwie do Chi Kwadrat, który porównuje model do danych. CFI jest rodzajem statystyki uchwycającej względną dobroć dopasowania lub dopasowanie hipotetycznego modelu jako empiryczny przyrost ponad prosty model (w szczególności ten w którym nie są estymowane ścieżki). W przeciwieństwie do Chi Kwadrat oraz SRMR, CFI jest wskaźnikiem dobroci dopasowania. Wyniki tej miary rozpościerają się od wyników 0,0 do 1.0, gdzie wyższe wyniki są lepsze. Również w przeciwieństwie do poprzednich dwóch wskaźników, CFI próbuje skorygować złożoność modelu. Robi to poprzez włączenie stopni swobody użytych w modelu bezpośrednio w obliczeniach.

Badanie Monte Carlo.

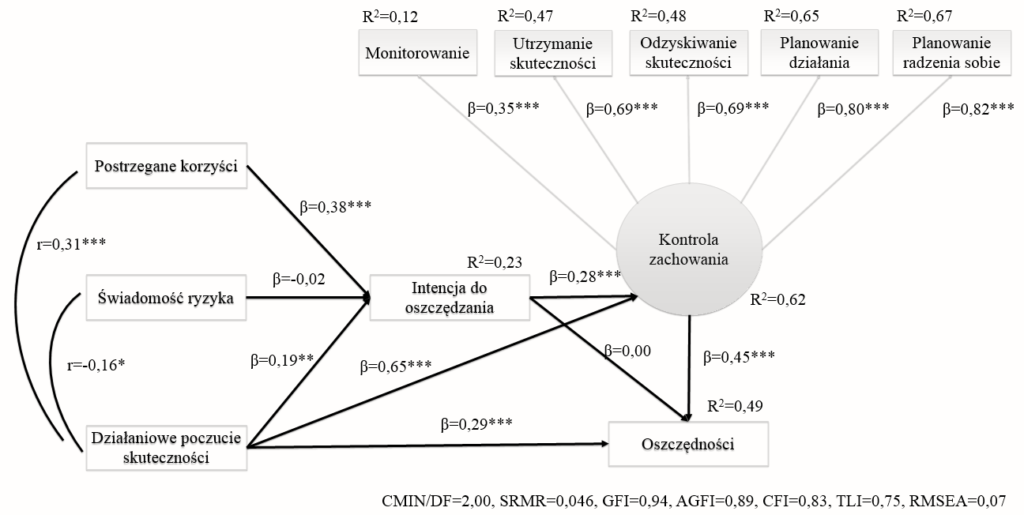

Uczeni często stosują symulację w analizie równań strukturalnych by testować pewne związki. Czynnik, dopasowania który dotyczy modelowania dobrych równań strukturalnych (SEM) jest powiązany z wielkością próby. Zobaczmy ilustrację tych wpływów na trzy statystyki dopasowania opisane powyżej. Rysunek poniżej przedstawia wpływ wielkości próby na na zmiany we wskaźnikach indeksów dopasowania.

Wielkość próby (Sample size).

W tej sekcji rozpatrzymy pytanie o wielkość próby z innego punku widzenia pytając o to „Jak dużo obserwacji jest niezbędne dla analizy by mieć dobry model SEM (analizy równań strukturalnych)?”. Wiele potencjalnych użytkowników ucieka od analizy równań strukturalnych ponieważ jest wrażenie, że wielkość próby musi być wyrażona w setkach. Jest to prawdą, że „większe jest zawsze lepsze” jeśli chodzi o wielkość próby. Ten truizm utrzymuje się szczególnie kiedy przewidywane efekty są subtelne, a pomiary nie są szczególnie czyste i rzetelne, a model strukturalny nie wprowadza bardzo wyraźnego rozróżnienia pomiędzy konstruktami. Zauważmy, że te stwierdzenie sugeruje – jeśli zmienne są rzetelne, efekty są mocne a model nie jest zbyt skomplikowany, mniejsze próbki będą zadowalać. By uzyskać smak tych powiązań, rozważmy następujące rzeczy. Było trochę myślenia, że silne, czyste pomiary (definiowane poprzez ilość zmiennych ładujących każdy czynnik oraz rzetelność czynników), były by nieco kompensujące dla wielkości próby, ale podczas gdy liczba zmiennych na czynnik ma wpływ na polepszenie statystyk dopasowania ten efekt jest skromny w porównaniu do rozmiaru próby. Co więcej, efekt ten może być niemonotniczny. Anderson & Gerbing (1991) uznają, że indeksy dopasowania są pogarszane przez liczbę czynników w modelu lub po prostu przez liczbę zmiennych. Jeśli tylko dwie zmienne ładują czynnik, może wystąpić błąd przy szacowaniu parametrów, ale jeśli są trzy lub więcej wskaźników na czynnik, ten błąd może niemal zanikać. W terminach redukcji błędu i nawet uzyskania modelu tylko do uruchomienia, autorzy Ci twierdzą, że dodatkową korzyścią jest, że przy „trzech lub więcej wskaźników na czynnik, wielkość próby N=100, będzie zwykle wystarczająca dla zbieżności”, a wielkość próby N=150 ” będzie zwykle wystarczająca dla konwergencji i właściwego rozwiązania.

Innym zapytaniem wzdłuż linii powiązań wśród charakterystyk modelu jest badanie współliniowości. Grawel, Cote i Baumgarthner (2004) uważają, że wysoka interkorelacja pomiędzy egzogenicznymi konstruktami to korelacja rzędu od 0,6 do 0,8, twierdzą również, że mogą w takim kontekście występować często błędy drugiego rodzaju we wnioskach (ścieżki mogą nie być istotne w przypadku kiedy rzeczywiście są istotne), o ile nie były ono mocno kompensowane siłą w danych, tak jak żyłowanie rzetelności i wielkości próby. Zarówno czynniki kompensujące służące do redukcji ogólnego błędu, użyczające większej precyzji i zaufania do parametrycznej estymacji.

Jest to trochę komfortowe, że modelowanie równań strukturalnych można wykonać dobrze nawet przy małej próbie (np N=50 lub N=100). Niejasna, ludowa reguła kciuka, rozważa wymaganą wielkość próby rzędu N>200, co może być zachowawcze i jest z pewnością uproszczone.

Badacze szczególnie troszczą się o wielkość próby i mogą liczyć pożądane N wymagane dla danego modelu (dla przykładu, przy ustalonej liczbie zmiennych, konstruktów – i co więcej – stopni swobody) i pożądać poziomu mocy lub odwrotnie szacować moc dla danego N.

Scenariusze różnych danych.

W tej finałowej sekcji, pokrótce odkrywamy kilka zaawansowanych tematów: moderację, dane podłużne, analizy czynnikowe wyższego rzędu, mediacje, wskaźniki odzwierciedlające oraz modele cząstkowych najmniejszych kwadratów.

Moderatory.

Pierwsze co musi zrobić badacz to zastanowienie się jak wprowadzić moderatory w model analizy równań strukturalnych (SEM). Moderator jest łatwym terminem interakcji i podejściem w analizie równań strukturalnych takim samym jak w analizie regresji. Zmienne efektów głównych są scentrowane, ich wskaźnik interakcyjny policzony oraz jako trzy zmienne są wprowadzane jako predyktory. Może być teoretyczne zainteresowanie tylko efektami głównymi, ale często włącza się jedynie jako statystyczną kontrole by pozwolić na czysto empiryczne skoncentrowanie się na interakcji. To podejście jest ogólne, pozwalając również na moderatory które są kategorialne lub ciągłe. Jeśli moderator jest kategorialny, inną opcją jest uruchomienie wielogrupowej analizy, w których model jest dopasowany do jednej grupy i ustawiony by sprawdzić numerycznie podobieńśtwo wskaźników dopasowania z drugą grupą.

Badania podłużne.

Badacze z podłużnymi danym, takimi jak powtórzone pomiary lub efekty wewnątrzgrupowe również mogą używać analizy równań strukturalnych (SEM). Są tutaj dwa rodzaje współczynników, które reprezentują efekty w czasie. Kilka z nich jest interesujących z teoretycznego punktu widzenia zobacz rys nr 3 poznanie w czasie 1 i afektu w czasie 2. Innych skutków działania jako statystycznych kontroli, takich jak efekty autokorelacji pomiędzy poznaniem w czasie 1 i 2 oraz owych afektów pomiędzy pomiarami w czasie 1 i 2.

Rysunek nr 3.

*Autokorealcje pomiarów są umożliwiane przez estymację korelacji między błędami (e1 <->e2), które są normalnie założone jako będące niezależne.

Analiza czynnikowa wyższego rzędu.

Kiedy zmienne zostaną zmierzone, czynnikowa analiza może być zastosowana z inną analizą czynnikową gdzie jest przeprowadzona jako macierz korelacji wśród czynników wydobytych w pierwszej analizie. Te pierwsze czynniki są nazywane czynnikami pierwszego rzędu, a te następne są nazywane czynnikami wyższego rzędu. Rysunek nr 4, przedstawia przykład 8 składnikowej ankiety, gdzie 4 pytania mierzą afekt, a 4 mierzą poznanie. W szczególności dwa aspekty afektu są zakładane i również dwa aspekty poznania. Jest wielce prawdopodobne, że dwa czynniki afektu są powiązane, jak również też 2 czynniki poznania. By dopasować czynniki wyższego rzędu w analizie równań strukturalnych PLS potraktuj zmienne jako y jako zmienne pierwszego rzędu, w wyższe poziomy jako czynniki endogenne.

Rysunek nr 4.

Analiza mediacji.

Popularnym zastosowaniem analizy równań strukturalnych jest zbadanie procesu przez który niezależna zmienna X wpływa na zmienną zależną Y bezpośrednio jako X->Y oraz pośrednio przez mediator X->M->Y. Tradycyjnie badacze mają dopasowania z serii regresji by estymować te związki, ale coraz częściej, statystyczni badacze wskazują na wyższość analizy równań strukturalnych w symultanicznym i bardziej efektywnym szacowaniu tych związków. Wszystkie trzy ścieżki są dopasowane na raz w pojedynczym modelu. Istotność współczynników ścieżkowych jest testowana i jeśli jest to pożądane, są one porównywane.

Wskaźniki odzwierciedlające/reflektywne

Część analizy czynnikowej w modelowaniu równań strukturalnych korzysta z bogatej i szerokiej literatury psychometrycznej datowanej na 1860r, kiedy Galton począł pomiar inteligencji. Jego filozofia i to, że Spearman i jego model czynnikowy który był istonie Platoniczny: nieobserwowalne było idealną, czystą formą, a obserwowalne było kombinacją idealnego i nieperfekcyjnego. Tłumacząc to na nasze cele, nieobserwowalne lub latentne czynniki były odzwierciedleniem obserwowanych zmiennych pomiarowych, a te zmienne były również poddane szumowi w formie systematycznych i losowych błędów. Tak więc, widzimy na rysunku nr 5, że rzekomy model może być podsumowany bardziej ogólnie poprzez model odzwierciedlony/reflektywny. Uczeni, którzy bronią wyższości odzwierciedlonego podejścia przez formowanie nowego przybysza oczerniają brak podstaw teoretycznych wspierających nowe podejście – nie ma tutaj psychometrycznej teorii by to wesprzeć. Wskazują oni liczne techniczne kwestie takie jak np. problemy w identyfikacji modelu. Wskazują również na fakt, że błąd pomiaru i błędy predykcji są naraz uwikłane. Rysunek nr 5 przedstawia filozofię odzwierciedlaną w kierunkach strzałek dla hipotetycznych konstruktów oznaczonych C, D, E (rozważymy A i B). Konstrukt C (w kółku, taki jak inteligencja lub postawa wobec reklam, rodzi pomiary C1, C2, C3 (w kwadratach) Błędy również są dołożone do tych pomiarów. Ludzie z większą inteligencją lub pozytywną postawą C uzyskują większe wyniki lub pozytywniejsze liczby w tych pomiarach. Mapowanie tego nie jest perfekcyjne i ta niedoskonałość jest odnotowana w e’ (błędy nie są równe wzdłuż c1, c2, i c3, ale indeksy te są eliminowane ze względu na zwięzłość. Na obrazku również Dzeta chwyta jak dobrze każda zmienna endogenna jest przewidywana – ten błąd strukturalny jest oznaczany jako 1 – R Kwadrat, tak więc jeśli wiemy, że D pomaga nam przewidzieć E bardzo dobrze wtedy Dzeta E będzie niska. Rysunek nr 6 pokazuje odzwierciedloną filozofię z trzema zmiennymi mierzącymi konstrukt C i czterema mierzącymi E. Z rzadka stwarza się ankietę gdzie skala nie istnieje i przybliżony pomiar pojedynczym wskaźnikiem może być praktyczny. Ten scenariusz jest reprezentowany przez zmienną D, gdzie tylko jeden item D1 jest dostępny do pomiaru konstruktu. W tym scenariuszu mapa pomiarowa jest przemyślana jako jeden do jednego, pomiar jest istotnie równy konstruktowi, tak więc ładunek czynnikowy jest tożsamy i błąd pomiaru jest ustawiony na zero. Nie ma sytuacji kiedy badanie ludzkiego zachowania jest ukazane poprzez podobną sytuację – nigdy nie mamy zerowego błędu pomiarowego. Tak więc pojedynczy składnik nie jest nigdy optymalny. Jakkolwiek są one czasem używane z praktycznych powodów. Wiemy, że wielokrotne składniki są pożądane i lepiej mieć pewien wskaźnik niż pojedynczy pomiar.

Wspomnijmy, że część wyższości SEM ponad regresje jest tym, że regresja miesza błąd przewidywania z błędem pomiaru. Brak dopasowania w 1-R kwadrat nie może być niejednoznacznie przypisany do niespecyfikowanego modelu lub słabych miar. W przeciwieństwie analiza modelowania równań strukturalnych pozwala na takie rozróżnienie, czynniki analitycznej części bierze pod uwagę błędy pomiaru i część strukturalnych ścieżek która ustala błąd predykcji modelu. Trochę czasu temu, badacze nie będący biegli w psychometrycznych teoriach wysnuli postulat, że strzałki pomiarów powinny iść w inną stronę. W ich podejściu zmienne łączy się by utworzyć konstrukt, co jest nazywane (formowanym pomiarem). Przykład ten jest rutynowo w użyciu (tak często, że można się zastanawiać czy istnieje inna alternatywna forma konstrukcji modelu) w socjoekonomicznym statucie (SES). Badacze twierdzą, że edukacja, dochody, zawód łączy się w SES i że zmiana w edukacji, dochodach lub zatrudnieniu zmienia SES, ale że jest odwrotnie nie jest prawdą. Ci badacze proponują mierzenie edukacji, dochodów i zatrudnienia jako całości w jednym pomiarze, jak widzimy konstrukt D jest mierzony osobno poprzez D1 w towarzystwie założenia miary bezbłędnej. Następnie regresja jest modelowana w której edukacja, dochód i zatrudnienie przewidują socjoekonomiczny status. Nie jest tu nic złego z regresją. Nie jest nic złego z pojedynczym pomiarem jako takim, aczkolwiek jest to teoretycznie niewyszukane i empirycznie problematyczne. Jednak „formatywnie” jako nowe pojecie lub podejście jest niepotrzebne i mylące. Powiedzmy, że proponowany formatywny pomiar jest zaledwie niekompletnym reflektywnym układem pomiarowym. Rozważmy konstrukty A i B na lewej stronie modelu. Formatywne podejście traktuje A i B jak D (jako pojedynczy składnik), przerywane strzałki i pudełka po lewej by nie istniały. Jakkolwiek nie ma powodu, że A i B nie mogą być uważane jako konstrukty w tradycyjnym sensie, latentne czynniki które są odzwierciedlane w wielokrotnym pomiarze, jako w przerywanych związkach A1-A3 i B1-B3. Jesli A jest konstruktem edukacji, A1 może być edukacją ojca, A2 może być edukacją matki a A3 edukacją najstarszego dziecka. Jeśli B jest dochodem, B1 może być totalnym dochodem gospodarstwa domowego, B2 może być dochodem nieregulowanym, a B3 moze być dochodem najstarszego dorosłego. Możliwe, że pomiary A i B są nadmierne i typowo pojedyncze, ale dla szacowania A i B są typowo wystarczające. Jakkolwiek wybór użycia pojedynczego itemu A i B dla celów praktycznych powinien nie być mieszany z teoretycznie nieuzasadnionym wyborem modelowania wypaczającym 150 letnią tradycję psychometrycznej teorii.

Rysunek nr 5.

Wnioski

Jesteśmy blisko z nowymi sugestiami odnoszącymi się do modelowania równań strukturalnych. Te komentarz są równie istotne dla badaczy budujących i testujących modele jak również dla recenzentów oceniających artykuły w których autorzy używali modelowania równań strukturalnych.

- Modelowanie równań strukturalnych nie jest przerażające – jest ona naturalna progresją analizy czynnikowej i analizy regresji.

- Można przeprowadzać SEM dla próbek większych niż co najmniej 50 obserwacji.

- Każdy konstrukt powinien być mierzony co najmniej przez 3 wskaźniki. Konstrukty mierzone przez cztery lub więcej zmiennych są prawdopodobnie bardziej rzetelne.

- Używaj metody największej wiarygodności (ona jest zwykle domyślną metodą)

- Sprawdź statystyki dopasowania

- Z drugiej strony zadaj dobre teoretyczne pytanie. Czy każde hipotetyczne powiązanie jest logicznie wsparte oraz czy model opowiada teoretyczną historię?

- Dopasuj co najmniej jeden konkurencyjny model na literaturze na której ogniskuje się budujący model, by zobaczyć i udowodnić poprawę.