Liniowa analiza dyskryminacji

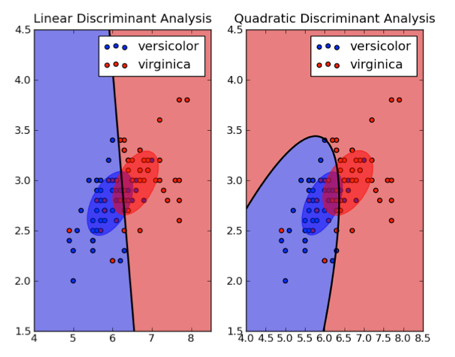

Celem liniowej analizy dyskryminacji (LDA) jest statystyczne rozdzielenie heterogenicznej populacji na dwie homogeniczne podgrupy i dalsze procesy decyzyjne na otrzymanych podzbiorach. Możemy założyć, że dla każdego kredytobiorcy istnieje określona liczba zmiennych go objaśniających. Główną ideą jest wyszukanie takiej liniowej kombinacji tych zmiennych, która wydzieli nam najlepiej homogeniczne podzbiory. W przypadku podziału jedynie na dwa podzbiory naszym celem jest znalezienie liniowej kombinacji zmiennych objaśniających, która pozostawi nam największy dystans między średnimi w obu otrzymanych grupach. W LDA przyjmujemy, że p(x|G) i p(x|B) pochodzą z wielowymiarowego rozkładu normalnego o jednakowych wariancjach. Równanie AG = {x|p(G|x) ≥cB/( cB + cG)} sprowadzamy do

AG = {x|∑aixi ≥ c} (1)

gdzie xi oznaczają zmienne objaśniające, a ai – odpowiednie wagi.

Metodę tę pierwszy wprowadził Fisher w 1936 roku. W jego analizie dyskryminacyjnej dążył on do znalezienia takiego kierunku a, który maksymalizuje odległość między zrzutowanymi średnimi obu prób przy uwzględnieniu wariancji rzutu (czyli standaryzowanej odległości zrzutu średnich). W ten sposób doszedł do następujących wyników:

a = W^T ((x_2 ) ̅-(x_1 ) ̅)

gdzie:

W = 1/(n-2) ∑_(k=1)^2▒〖∑_(l=1)^(n_k)▒( x_kl 〗-x ̅_k)〖(x_kl-x ̅_k)〗^T

I ostatecznie otrzymał następującą regułę dyskryminacyjną:

jeśli aT (x − x2−2×1 ) > 0 wtedy wektor x należy do grupy k = 2, w przeciwnym razie – do grupy k = 1. Doboru zmienny do modelu można dokonać na wiele różnych sposobów. Jedną z metod jest regresja krokowa (postępowa lub wsteczna), która polega do dobieraniu (lub odrzucaniu) kolejnych zmiennych za każdym razem wyliczając wartość kryteriów informacyjnych i decydując na tej podstawie o tym czy zmienna ma pozostać w modelu czy też nie. Można również posłużyć się otrzymanymi wartościami wag ai i w zależności od ich wartości wybrać odpowiedni model.

Dopiero w 1968 roku Altman wykorzystał analizę dysryminacyjną w zarządzaniu finansami. Opracował on swój model (zwanym modelem Zeta Score), posługując się próbą 66 korporacji amerykańskich reprezentujących po 33 spółki z każdej grupy (bankrutów i niebankrutów). Dane do wyznaczenia współ-czynników dyskryminacji zaczerpnął ze sprawozdań finansowych sporządzonych w roku sprawozdawczym poprzedzającym bankructwo spółki. W swoich rozważaniach Altman uwzględnił początkowo 22 wskaźniki finansowe spośród których wybrał ostatecznie pięć, według niego najbardziej istotnych w predykcji bankructwa. Ostatecznie przedstawiona przez Altmana funkcja dyskryminacyjna miała postać:

Z = 1,2 · x1 + 1,4 · x2 + 3,3 · x3 + 0,6 · x4 + 1,0 · x5 (4)

gdzie:

x1 = kapitał obrotowy

aktywa ogółem

x2 = zysk zatrzymany

aktywa ogółem

x3 = zysk przed opodatkowaniem i spłatą odsetek

aktywa ogółem

x4 = wartość rynkowa kapitału

całkowite zadłużenie

x5 = przychody ze sprzedaży

aktywa ogółem

W tych badaniach wartością dyskryminacyjną okazała się liczba 1,81. Dla analizowanej próby Altman ustalił prawdopodobieństwa zbankrutowania badanych korporacji np. korporacja dla której funkcja dyskryminacji wynosi −0,55 zbankrutuje z prawdopodobieństwem 75%, natomiast prawdopodobieństwo zbankrutowania korporacji, dla której funkcja dyskryminacji przyjmie wartość 2,3 wynosi 1%. Altman i jego współpracownicy w pózniejszych latach ulepszali ten model, stosujac techniki oczyszczania danych z wpływu czynników losowych. W 1984 roku Altman wykazał, że modele służące do przewidywania upadku przedsiębiorstwa powinny być tworzone dla konkretnego kraju, w którym będą później używane. Przyczyną są między innymi różnice w systemach rachunkowości obowiązujących w różnych krajach. Modele Altmana były stosowane dla polskich spółek giełdowych, jak przewidział Altman, z kiepskim rezultatem. Dlatego też w 1996 roku model dyskryminacyjny na podstawie danych pochodzących z polskiego sektora zbudowali J.Gajdka i D.Stos. Swoją analizę autorzy oparli na próbie 40 spółek giełdowych, 20 bankrutów i 20 spółek nadal funkcjonujących. Za bankrutów Gajdka i Stos uznali przedsiębiorstwa które:

rozpoczęły proces likwidacji spowodowanej sytuacją finansową,

zawarły układ sądowy z wierzycielami

podpisały ugodę bankową dokonaną na podstawie Ustawy o Restrukturyzacji Finansowej Przedsiębiorstw i Banków.

Na podstawie analizy sprawozdań finansowych z roku poprzedzającego rok bankructwa autorzy wybrali pięć wskaźników, najbardziej istotnych. Otrzymali w ten sposób następującą funkcję dyskryminacyjną:

Z = 0,773 − 0,086 · x1 − 0,0008 · x2 + 0,922 · x3 + 0,654 · x4 − 0,595 · x5 (5)

gdzie:

x1 = przychody ze sprzedaży

aktywa ogółem

x2 = zobowiązania krótkoterminowe * 365

koszty wytworzenia produkcji sprzedanej

x3 = zysk (strata) netto

aktywa ogółem

x4 = zysk (strata) netto

przychody ze sprzedaży

x5 = całkowite zobowiązania

aktywa ogółem

Wartość graniczna wyznaczająca podział pomiędzy grupami bankrutów i niebankrutów to 0, 45.

W późniejszych latach powstało dużo innych modeli, również dla sektora polskiego (m.in. model Hołdy). Efektywność funkcji dyskryminacyjnej jest uzależniona od spełnienia pewnych założeń. Chodzi tu przede wszystkim o wymagania dotyczące istnienia wielowymiarowego rozkładu normalnego, a także istotne zróżnicowanie macierzy kowariancji w obu rozpatrywanych populacjach oraz ciągłego charakteru analizowanych cech. W praktyce jednak weryfikacja założeń nie jest należycie przeprowadzana. Nie zawsze też można wymagać od badanej populacji, że założenia te będą spełnione. Warto jednak pamiętać, że dużą zaletą tej metody jest jej prostota i wysoka skuteczność na danych spełniających założenia. Co ciekawe aby ominąć warunek o równości macierzy kowariancji w grupach w późniejszych latach wprowadzono kwadratową analizę dyskryminacji. Jednak jej wyniki okazały się ekonomicznie nieinterpretowalne i przy użyciu nowych przypadków kredytowych okazała się ona bardzo niestabilna.

http://www.statsoft.pl/textbook

Vojtek M., Kocenda E. (2006) Credit Scoring Methods. Czech Journal of Economics and Finance 56: 3-4.