Społeczność antynaukowa okiem psychologa, metodologa i statystyka w jednej osobie.

Wstęp.

Nie chcę być postrzegany jako komuch lub nie wiem kto. Niemniej w kapitaliźmie autorytetem staje się często miernota moralna, dlatego też mamy wszelkie powody ku temu, aby w obecnej sytuacji rozwojowej historii kultury i techniki ludzkiej uważać ignorowanie nauki za najgroźniejsze ze wszystkich niebezpieczeństw. Nie poprawimy szansy na stawienie czoła fundamentalizmom antynaukowym traktując je jako zjawiska przejściowe i dotyczące małej liczebności populacji. Może natomiast sprostamy temu poprzez zbadanie łańcucha przyczyn, które wpływają na to, że ludzie wchodzą w te niezbyt rozsądne ruchy społeczne.

Ze względu na moje osobiste zaniepokojenie sytuacją związaną z ciągłymi doniesieniami o rosnącej grupie zwolenników osób, które propagują wątpliwą perspektywę zdrowego trybu życia, postanowiłem napisać tekst dotyczący mojej oceny sytuacji i perspektywy możliwości uporania się z tym problemem społecznym. Nie znam się na ruchach antynaukowych, a także nie znam się na walce z nimi. Niemniej to co jawi mi się w internecie, a także w życiu codziennym, a mówię tu konkretnie o manifestowaniu niebywale pewnych oraz mglistych poglądów na zdrowe życie przez różne i dziwne osoby, wymusza na mnie zajęcie konkretnego stanowiska wobec takiego typu praktyk, a także wsparcia osób wrażliwych na tego rodzaju manipulację.

To co chciałbym przekazać ludziom, którzy wahają się przy wyborze stylu życia lub praktykowania pewnych działań skierowanych na siebie (mówię tu o praktykach zdrowotnych i dbaniu o własnego ducha oraz ciało) to, to że mogą wziąć sobie do serca co tutaj piszę i pokontemplować chwilę nad sobą i własnym życiem. Dla zwykłego człowieka kluczowe w podjęciu decyzji o sobie samym jest ważne, aby zapoznał się z informacjami po obu stronach barykady. Jest to niezwykle trudne i czasochłonne. Niemniej co w życiu jest proste i szybkie prócz zupek chińskich z paczki?

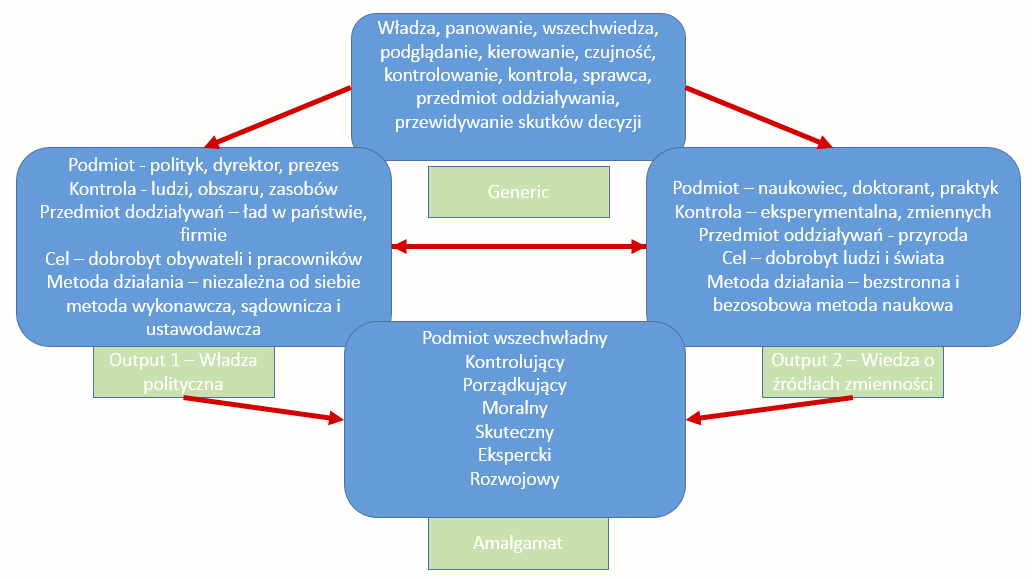

Nauka i metodologia.

Nauka jeszcze nie, ale metodologia badań brzmi dosyć kosmicznie i nie dla każdego jest to pojęcie znane. Zacznijmy od tego, że postęp naukowy oraz techniczny jest zależny od metod badań. Metody badań są to czynności niezbędne, by uchwycić choć w drobnej cząstce naturę, która nam wszystkim się jawi w swej całej okazałości i prawidłowości. Najprostszą metodą badania jest obserwacja, czyli zwykłe obserwowanie danego obiektu rzeczywistości. Wystarczy, że będziemy przez jakiś czas obserwować np. życie pewnego człowieka, a będziemy mieć rzetelne informacje o kluczowych momentach i zdarzeniach mających dla niego przełomowe znaczenie w kontekście jego zmiany zachowania np. śmierć bliskiej osoby, pierwsza praca i choroba. Drugą metodą na której chciałbym się skupić to metoda eksperymentalna. Podkreślam ją dlatego, że jest to królowa nauki. W skrócie polega ona na wywołaniu pewnych przyczyn zjawiska i pomiarze konsekwencji z tego wynikających, a także porównaniu tych wyników z grupą kontrolną w której danego zjawiska nie wywoływano. Prosty przykład. Jednej grupie uczniów podajemy na stołówce przesoloną zupę, natomiast drugiej dajemy zupę posoloną optymalnie, a następnie sprawdzamy ile wody wypiją. Dzięki takiemu ilościowemu podejściu możemy wnioskować o pewnych rzeczywistych zależnościach rządzących naturą, a w tym kontekście życiem ludzkim. Jak metoda ma się do nauki? Dzięki metodom badań, ich dopracowywaniu, tworzeniu nowych instrumentów pomiarowych, a także krytykowania różnych metodologii możemy coraz dokładniej badać otaczający nas świat. Nauka i metody badań idą ramię w ramię tworząc nową wiedzę oraz niewiedzę. Niewiedzę? Jak to? Tak to. Każda nowa wiedza wywołuje nową niewiedzę. Każde nowe odkrycie pociąga za sobą kolejne pytania i stawia liczne wątpliwości. Np. co jeszcze dzieje się z dziećmi pod wpływem soli?; Czemu po soli tyle się pije?; Co może spowodować, że nie trzeba pić tyle wody?; itd. itp. Stan wiedzy jest zawsze tymczasowy i niezbyt pewny, choć pewny na tyle, że można mu ufać. Niemniej w kontekście podejmowania decyzji wiedza ta jest nieoceniona dla życia i rozwoju ludzi, a także całych społeczeństw oraz kultur. Naukowcy, technicy, przemysł, a także cały świat wiedzy nie jest spiskującym przeciwko ludziom molochem. Jest raczej Pewnego rodzaju misją polegającą na tym, by ułatwić i umilić życie ludziom.

Spiski naukowe – Wielkie koło informacji, nadziei i wątpliwości.

Codziennie jesteśmy zalewani informacjami dotyczącymi odkryć naukowych mających zrewolucjonizować lub poprawić jakość życia. Dziennikarze oraz media (o zmiennej rzetelności jednych i drugich) komunikują ludziom nowe i fenomenalne odkrycia naukowe. Odkrycia te są niekiedy przełomowe i bardzo ważne w postępie naukowym i wynalazczym. Niemniej są one na tyle nowe, że konieczne są dalsze nad nimi badania. Są one wykonywane po to, by nie były one zagrożeniem dla ludzi, ekonomii, a także niekorzystnych zmian społecznych. I tu pojawia się pewien zgrzyt między oczekiwaniami zwykłych ludzi, a światem nauki. Wynika on głównie z tego, że odkrycia naukowe są przedstawiane przez dziennikarzy jako zbawienie i remedium, że wystarczy ich użyć, by naprawić świat. Zazwyczaj takie uproszczone komunikowanie doniesień naukowych sprawia, że ludzie mają pewne oczekiwania i nadzieje. Te ostatnie są jedynym co zostało osobom będącym w sytuacjach beznadziejnych (choroby, urazy, niepełnosprawność, przemoc itp.). Te oczekiwania i nadzieje nie są spełniane, ponieważ dalsze badania nad danym zagadnieniem wymagają czasu i ogromnej pracy wysoko wyspecjalizowanej kadry specjalistów, często niezależnych od siebie zespołów, a czasem wręcz naukowców ze sobą konkurujących (choć konkurencja ta w świetle nauki i postępu jest raczej postrzegana jako zdrowa i pożądana). Czas między odkryciami, a wykorzystaniem ich wyników w praktyce społecznej jest procesem, a nie rewolucją. I w tym właśnie momencie, i na tej właśnie podstawie swoje „wici” rozwijają osoby, które świadomie bądź nie „smażą” pieniądze na szarych obywatelach mających wielkie nadzieje w alternatywnych metodach, praktykach leczenia i zachowywania się. Obywatele mają te doniesienia z tyłu głowy i w odpowiednim momencie mogą się one aktywizować. To w jakim kontekście te informacje będą przywołane będzie determinowało dalszą ich ocenę. Ludzie się różnią i z tego zróżnicowania wynika bardzo wiele ważnych kwestii. Z perspektywy psychologicznej i statystycznej zawsze w społeczności ludzi znajdzie się grupa osób wrażliwych, która będzie skłonna wejść tę przestrzeń praktyk i oddać się pod mentalną opiekę oraz wytyczne swego alternatywnego guru. Zawsze znajdą się osoby lub nawet grupy osób, które są niestabilne emocjonalne, trochę mniej inteligentne, introwertywne, bez wsparcia, zalęknione wielkim i bezlitosnym światem zewnętrznym, chcące troszczyć się o ten skromny kawałek tożsamości jakim jest ich głos przeciwko sztucznie wykreowanemu przez guru „złu”, a także pragnące nakarmić nadzieje nowymi sposobami leczenia, zarobku lub zachowania. Wpływ na działanie takich osób, na zmianę ich postaw, myślenia oraz odczuwania nie jest zarówno, ani skomplikowany, ani zakazany prawem. I musimy powiedzieć sobie jasno, że mniej lub bardziej świadome manipulowanie tą grupą społeczną ma bardzo negatywne konsekwencje w przypadku chorób i trudnych sytuacji w jakich Ci ludzie się znajdują. Sztandarowym przykładem jest to, że dla nich pierwszą instancją kontaktu jest negatywnie zindoktrynowana rzesza ludzi myślących podobnie jak oni i zachowujących się bardzo stronniczo w kontekście pomocy w sytuacjach trudnych (choroby, zachowania, uzależniania, porady prawne itp.). Jakie to może mieć skutki? Wszyscy wiemy…

*Najzabawniejsze jest to, że niektórzy alternatywni guru robią całkiem dobrą, fajną i pożądaną robotę w kwestii promocji zdrowego trybu życia. Jest to niebywały fenomen. Niemniej z drugiej strony, jeśli twierdzenia tych guru nie wytrzymują zwykłej chłopskiej krytyki lub ich twierdzenia nie mogą być zweryfikowane, to hallooo, nooo chyba coś jest jednak nie tak. Do tego dochodzi sam fakt istnienia pewnego rodzaju pewności w ich stanowiskach… wobec ich pewnych i ostatecznych zaleceń powinien włączać się czerwony alarm w umysłach ludzi odbierających narrację tej jakości. Podkreślam. W życiu pewna jest tylko śmierć i podatki.

Co robić i jak żyć?

Wydaję mi się, że osoby które poddały się wyżej opisanemu wpływowi wraz ze swoimi bliskim oraz są skrajnymi zwolennikami teorii spiskowych, alternatywnych form terapii i życia, trudno wchodzą w jakikolwiek merytoryczny dialog. Są zamknięci i wyczuleni na jakikolwiek wpływ w kierunku ich zbiorowej, a także indywidualnej tożsamości. Ich zmianę może wywołać jedynie modyfikacja prawa przez ustawodawcę, ale to jest bardzo trudne we wdrożeniu i kontroli. To jak można się z nimi komunikować to np. przekaz jednostronny, który jest nastawiony na ukazywanie ryzyk, negatywnych konsekwencji wynikających z ich podejścia, ale również przedstawiania korzyści jakie niesie zmiana na pronaukowy styl życia oraz to jak można to zrobić. Poza tym rozsądnym wydaje się wpływanie na opinię i postawy osób będących „pomiędzy” przez promocję nauki dzięki oddolnym ruchom naukowców oraz ustawodawców. To właśnie z takimi osobami, które nie są zbyt zmącone ideologią alternatywnych guru oraz nie są zamknięte na sprzeczne informacje, można pracować i ich można łatwiej przekonać co do tego, że nauka wraz ze swoim dorobkiem oraz tradycją, a także z rozsądkiem danym ludziom może wyciągać z niedoli. Wynika to z faktu, że osoby te nie mają jasno sprecyzowanych poglądów i prawdopodobnie są chętne oraz otwarte na ważenie informacji o alternatywnych i naukowych doniesieniach. W przypadku antynaukowych fundamentalistów merytoryczne argumenty są nie do przyjęcia, bo nie podzielają ich poglądów i tradycyjnych zwykle, recept na życie. To co można zmienić w samym dialogu naukowym i jego komunikowaniu to zmiana znaczeń, sposobu sprawozdawczości wyników badań, interpretacji argumentów naukowych, pokazywania ich na zasadzie metafor i analogii, by mogły one trafiać do przeciętnego człowieka.